Muita gente repercutiu o anúncio de Musk como se fosse quase um game-over para os competidores, como se agora ele fosse o único com uma infraestrutura para treinar as próximas gerações de IA. Porém, a coisa não é bem assim.

O diferencial do "Colossus" é ter criado em uma infraestrutura em cluster integrando a quantidade absurda de 100 mil GPUs, mas isso não quer dizer que os concorrentes não tenham capacidade de fazer frente a esse lançamento.

Para se ter uma ideia do que eu estou falando, Mark Zuckerberg havia anunciado no começo deste ano o plano de adquirir 350 mil GPUs H100 para treinar a próxima geração de IA com a promessa de se aproximar da Inteligência Artificial Geral (AGI).

De acordo com o CEO da Meta, a empresa chegará no fim do ano com um poder computacional equivalente a 600 mil GPUs H100, quando levado em consideração outras GPUs que a organização já possui.

Esse montante de processadores de última geração das Bigtechs é tão absurdo que perdemos o senso da realidade.

É difícil imaginar o que seria um cluster de 100 mil GPUs H100, por exemplo, mas precisamos materializar esses números para entender como o mundo está se dividindo a partir das diferenças do poder computacional entre as regiões.

Abismo entre Norte e Sul

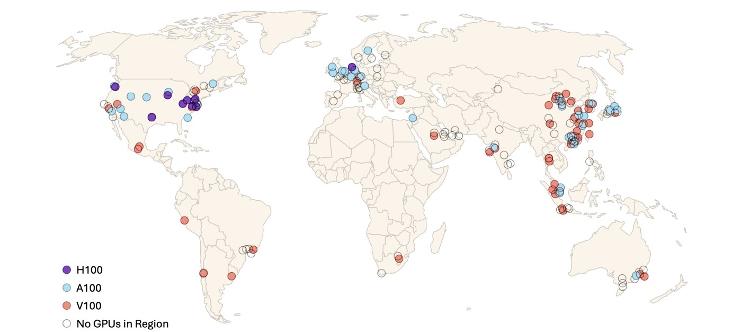

Nesta semana, eu li um estudo de pesquisadores de Oxford, Aalto University da Finlândia e a Universidade Nacional da Austrália, que traz quase que um censo global da infraestrutura computacional para o treinamento de IA.

A partir da análise dos principais provedores de computação em nuvem, os pesquisadores mostram um verdadeiro abismo entre o Norte e o Sul, e também entre os EUA e o resto do mundo.

De acordo com os dados levantados, os EUA são o único lugar do mundo que tem vários ambientes com a GPU H100 de última geração.

A China, por exemplo, tem sua infraestrutura baseada nas gerações anteriores de GPUs (A100 e V100), mas nenhum ambiente de alto poder computacional baseado na H100, o que pode ser uma das consequências das dificuldades impostas por Washington.

No entanto, não podemos afirmar categoricamente que a China não possua nenhum ambiente baseado na GPU H100. O estudo levou em consideração apenas dados públicos e oficiais, mas é importante lembrar que existem muitos ambientes "clandestinos" no país asiático.

O The Wall Street Journal fez uma reportagem sobre rotas de contrabando de GPUs dos EUA para China, com pessoas escondendo processadores em suas malas para abastecer o mercado local.

Ainda assim, ninguém vai conseguir levar 100 mil processadores, o que escala ainda mais a guerra dos chips entre os dois países.

E o Brasil na corrida da IA?

Quando olhamos para o Brasil, a situação é ainda mais assustadora.

De acordo com o estudo, o Brasil não tem nenhum ambiente de nuvem com GPUs H100 ou A100. O país tem apenas um único ambiente, mas baseado nas GPUs V100, o modelo antigo de 2017.

Assim como no caso da China, não dá para afirmar que não exista nenhuma infraestrutura baseada em H100 no Brasil.

Pode até existir infraestrutura com esse tipo de processador em startups ou centros de pesquisas, mas quando o estudo analisou os grandes provedores de nuvem, descobriram que a tecnologia hospedada no país é bem defasada.

Um dos objetivos do Plano Brasileiro de IA, apresentado recentemente pelo MCTI (Ministério da Ciência, Tecnologia e Inovação), é tentar diminuir essa diferença a partir de investimentos para atualizar a nossa infraestrutura computacional.

Ao todo, o plano prevê R$ 3 bilhões para o "Programa Nacional de Infraestrutura para IA", sendo que 1,8 bi será destinado apenas para a atualizar o supercomputador Santos Dumont, hospedado no Laboratório Nacional de Computação (LNCC).

Eu tenho muitas dúvidas sobre esse ponto, porque muitos dos supercomputadores científicos não são desenvolvidos pensando nas particularidades da IA.

Por exemplo, no site do supercomputador Santos Dumont, a especificação diz que a infraestrutura atual para IA possui apenas 8 GPUs V100. O que é isso perto das 100 mil GPUS H100 dos Musk?

Na entrevista que fizemos com a ministra Luciana Santos no "Deu Tilt", podcast do UOL sobre tecnologia e inovação, questionamos exatamente sobre esse ponto.

Ela nos respondeu que o Brasil está começando as conversas com a Nvidia, a principal fornecedora de GPU, mas que ainda não existe nada definido.

Além do questionamento de como vamos montar a infraestrutura, resta saber se teremos dinheiro suficiente.

Cada GPU H100 custa por volta de R$ 30 mil, o que significa que Elon Musk pode ter gastado virtualmente algo em torno de US$ 3 bilhões para construir seu supercomputador.

Digo virtualmente, porque o projeto é uma parceria com a Nvidia e pode ter tido descontos e outras formas de compensação.

Quando convertemos o valor de dólares para o real, chegamos a um custo de aproximadamente R$ 16 bilhões, sem levar em consideração impostos e custos logísticos.

Este é um valor bem distante dos 3 bilhões do "Programa Nacional de Infraestrutura para IA".

O Brasil deu um primeiro passo com o Plano Brasileiro de IA, mas quando olhamos para a realidade vemos que o abismo no mundo tecnológico entre as diferentes regiões está cada vez mais profundo.

Opinião

Texto em que o autor apresenta e defende suas ideias e opiniões, a partir da interpretação de fatos e dados.

** Este texto não reflete, necessariamente, a opinião do UOL.

há 7 meses

41

há 7 meses

41

English (US) ·

English (US) ·  Portuguese (BR) ·

Portuguese (BR) ·